Más de 100 dossieres, diagramas, protocolos de actuación y hojas de cálculo sospechosamente filtradas a los periodistas de The Guardian. Todo el manual de estilo con el que los responsables de contenidos de Facebook actúan sobre las publicaciones de contenido racista, sexual o violento ha salido a la luz, mostrando al mundo cómo la gran red social vela porque nadie comparta materiales sensibles o peligrosos y que sirven, además, para avisar a todos los usuarios del mundo dónde está el límite. ¿Se trata de un descuido o de una difusión interesada para promover la autocensura? Esto es lo que se puede y no se puede publicar en Facebook.

Uno de los criterios de censura más destacado por The Guardian es el que afecta a figuras de relevancia pública y, más en concreto, a Donald Trump. El presidente, objeto de cientos de miles de comentarios cada día, goza de un nivel de protección mayor. Así, cualquier expresión que aluda a su muerte como, por ejemplo, "Que alguien dispare a Trump", es borrada automáticamente, mientras que otras que únicamente lo insultan o desean su desaparición sí son permitidas.

Los vídeos o fotografías de maltratos a menores cuentan con un capítulo exclusivo. Porque Facebook establece un criterio de ‘concienciación’ al respecto. De esta forma, los contenidos en los que aparecen niños siendo objeto vejados o golpeados pueden mantenerse, siempre y cuando sirvan para sensibilizar a los usuarios, y solo son eliminados si son demasiado extremos o si los responsables de la red social detectan que esas actividades son celebradas en los comentarios.

El objetivo de la plataforma dirigida por Mark Zuckerberg es ayudar a que estos niños sean identificados y rescatados. Algo similar ocurre con lo relativo al maltrato animal: solo las imágenes más extremas son marcadas como "perturbadoras".

Por otro lado, la red también permite la transmisión en directo de los intentos de autolesión que algunos usuarios comparten en sus perfiles, puesto que "no quiere censurar o castigar a gente que está sufriendo". Y lo mismo con los vídeos de muertes violentas: aunque marcados como inquietantes, no todos tienen por qué ser eliminados porque pueden ayudar a generar conciencia sobre determinados temas como las enfermedades mentales.

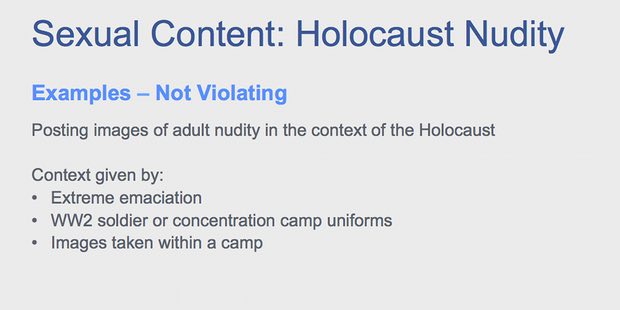

Y, ¿qué sucede con los desnudos? Tras la polémica por haber censurado la icónica imagen de la niña desnuda del Napalm, Facebook aclara que tan solo permite "excepciones noticiosas que no incluyen imágenes de desnudez infantil en el contexto del Holocausto" y representaciones artísticas de desnudos o actividades sexuales siempre y cuando sean manuales, nunca digitales.

La polémica ha sido inmediata. ¿Por qué Facebook sí elimina al instante las frases amenazantes contra Trump pero, en cambio, tolera las que alientan a asesinar animales, por ejemplo? La responsable de la gestión global de políticas de la compañía, Monika Bickert, explicó a The Guardian que Facebook es "una comunidad global muy diversa y la gente va a tener ideas muy diferentes sobre lo que está bien compartir. No importa dónde dibuje la línea; siempre habrá algunas áreas grises".

Bickert, dijo también que los moderadores cuentan con unos diez segundos para determinar si los contenidos deben o no ser eliminados: "Trabajamos duro para hacer que Facebook sea tan seguro como sea posible, mientras posibilitamos la libertad de expresión".

Crédito de la imagen: www.instagram.com/antonzhuman/